银河官网自然语言处理与智能软件研究团队研究生池俊龙等在CCF T1类期刊发表研究成果

yh533388银河/学院动态2024-03-14 14:24:00来源:yh533388银河评论:0点击:收藏本文

近日,银河官网自然语言处理与智能软件研究团队研究生池俊龙同学(导师:曾碧卿教授),在CCF A类中文期刊《中国科学:信息科学》发表研究成果“基于上下文增强的多级注意力会话推荐模型”,该期刊也是我校计算机科学与技术学科代表性成果推荐目录中的二类层次期刊。本论文于2023年4月18日投稿,2024年3月11日接收。

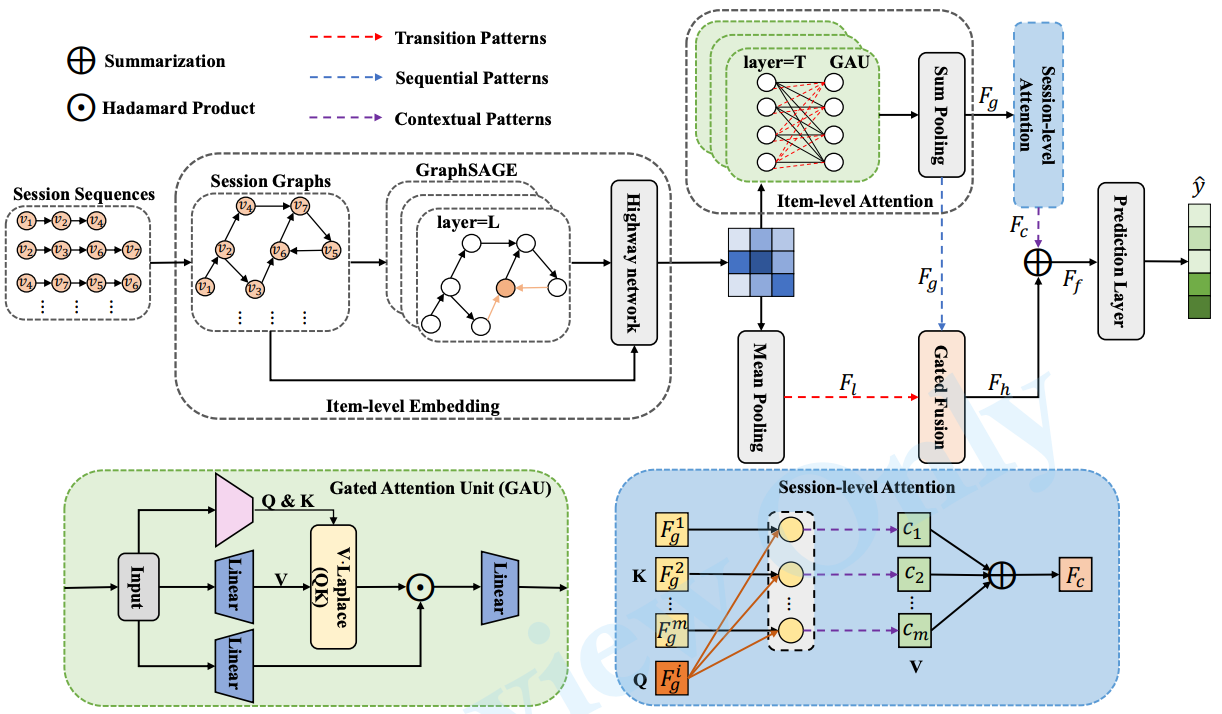

会话推荐的目标是仅根据用户在匿名会话中有限的交互行为,来预测用户的下一次点击行为。最近几年,许多基于图神经网络的会话推荐方法取得了可喜的结果。然而,这些方法仍然存在不足之处。一方面,基于图神经网络的方法只考虑物品之间的转换模式,忽略了会话中的序列模式。另一方面,现有的大多数方法都只关注当前会话内部的信息,忽略了来自邻居会话的外部协作信息,即上下文模式。为了解决上述问题,本文提出了一种新颖的基于上下文增强的多级注意力会话推荐模型(CEMA),通过多级注意力机制分别在物品级和会话级这两个粒度上学习物品特征和建模用户偏好,以增强模型的个性化推荐能力。CEMA模型利用多层GraphSAGE来学习物品之间复杂的转换模式,以捕获用户的局部偏好。特别地,在CEMA模型中设计了一种物品级注意力机制,通过门控 注意力单元来计算会话中不同物品的重要性,以识别用户真正感兴趣的物品,避免噪声物品的干扰。这有助于准确地捕获会话的序列模式,以建模用户的全局偏好。此外,所提出的方法还设计了一种会话级注意力机制,通过简单的软注意力高效地计算不同会话之间的相似度,以聚焦于那些与当前会话最相似的邻居会话,并从中提取上下文模式,以帮助预测用户的下一次点击。本文在三个公开的基准数据集上进行了一系列实验,实验结果表明CEMA的推荐性能超过了现有最好的方法,充分验证了CEMA的有效性和优越性。

CEMA模型总体流程图如下图所示:

本论文的创新点总结如下:

1)提出了一个新颖的 CEMA 模型,它结合了图神经网络和注意力机制各自的优势,充分地利用并整合会话内部的转换模式和序列模式,以及不同会话之间的上下文模式,增强了会话推荐性能。

2)提出了一种物品级注意力机制,通过应用强大且高效的门控注意力单元 (GAU) 计算会话中不同物品的重要性,聚焦用户真正感兴趣的物品,以帮助捕获用户的真实意图,从而得到更为准确的长期序列依赖关系。本文是第一个在会话推荐任务中应用GAU来捕获会话序列信息的工作。

3)设计了一种会话级注意力机制,它是一种简单高效的软注意力机制,可以快速地计算不同会话之间的相似性,并有效地从邻居会话中提取上下文信息。

4)在 Diginetica、Retailrocket 和 Tmall 这三个公开的基准数据集上进行了详细的实验和分析,实验结果表明CEMA的性能超过了现有的最佳会话推荐方法,证明了CEMA的有效性和优越性。

本论文受国家自然科学基金面上项目、国家自然科学基金项目、广东省基础与应用基础研究基金项目、广东省普通高校人工智能重点领域专项和广州市基础研究计划基础与应用基础研究项目资助。

撰稿:池俊龙

审稿:陈锦辉